Entwicklung eines Sensoraufbaus zur Realisierung autonomer Anwendungen auf Binnengewässern

In der Schifffahrt besteht derzeit ein intensives Bestreben, die Sicherheit durch Automatisierung deutlich zu erhöhen. Unfallstatistiken belegen, dass gerade auf Binnenseen und im Küstenbereich die Zahl der durch Unachtsamkeit verursachten Unfälle bisher unverändert hoch ist. In der Komplexität sind die Verkehrsszenarien auf Binnenseen denen im Straßenverkehr durchaus vergleichbar, zeichnen sich aber durch eine Vielzahl von Besonderheiten aus. So gibt es eine eindeutige Spurführung nur vereinzelt in Ufernähe, Manöver anderer Verkehrsteilnehmer sind häufig schwer abschätzbar bzw. vorhersagbar. Den Verkehrsraum teilen sich verschiedenste Wasser-Fahrzeugtypen, inklusive schwimmender Personen. Gleichzeitig erschwert die durch den Wellenschlag verursachte Eigenbewegung der Sensorplattform eine Interpretation der aktuellen Verkehrs- und damit auch die Einschätzung der Gefahrenlage.

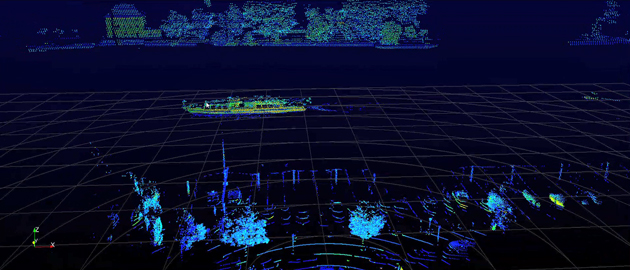

Um ganz oder teilweise autonom operierende Wasserfahrzeuge realisieren zu können, ist insbesondere die zuverlässige, detaillierte und über weite Distanzen reichende Aufnahme der aktuellen Szene sowie die robuste Zustandsschätzung und Klassifikation von Objekten von erheblicher Bedeutung. Mit den im maritimen Kontext fast ausschließlich eingesetzten Radar-Sensoren ist dies nicht in der erforderlichen Güte und Detaillierung möglich. Vielmehr bieten sich hier optische Sensoren verbunden mit LIDAR (siehe obige Abbildung) an, um ein entsprechend geeignetes Abbild der komplexen dynamischen 3D-Szene zu erstellen und diese dann Tracking- und Klassifikationsalgorithmen zur Verfügung zu stellen. Innerhalb des Projekts soll diese Problematik durch ein interdisziplinäres Team, bestehend aus Mitarbeitern des Instituts für optische Systeme (IOS) und des Instituts für Systemdynamik (ISD), in folgenden Punkten angegangen werden:

- Ausgehend von einem Multisensorsystem (Lidar gekoppelt mit multiplen Kameras) wird die Umgebung zu jedem Zeitpunkt als ein Satz von unregistrierten 3D-Punktwolken und Farbinformationen erfasst. Diese Daten dienen als Input für eine im Rahmen des Projekts zu entwickelnde Deep-Learning Architektur. Im Gegensatz zu den heute eingesetzten Convolutional Neural Networks müssen diese neuronalen Netze mit den für 3DPunktwolken typischen Messpunkten ohne feste Nachbarschaftsbeziehungen zurechtkommen.

- Mithilfe dieser Netzwerke lassen sich Objekte innerhalb der Punktwolken des jeweiligen Sensors in Echtzeit detektieren und klassifizieren sowie sensorspezifische Tiefenkarten erstellen. Die resultierenden Objektlisten und Tiefenkarten sind an diesem Punkt weder zwischen den einzelnen Sensoren, noch über die einzelnen Zeitschritte hinweg miteinander fusioniert. Diese Fusion erfolgt erst im nächsten Schritt. Aufgrund dieser sehr spät erfolgenden Fusion lässt sich das Multisensorsystem modular aufbauen, was gleichzeitig eine sehr robuste Fusion auf Basis der durch das Netzwerk bereits stark vorverarbeiteten Einzelsensordaten ermöglicht.

- Mithilfe von Verfahren zum Tracking multipler ausgedehnter Objekte werden die Objektlisten und Tiefenkarten der einzelnen Sensormodalitäten fusioniert, so dass die detektierten Objekte klassifiziert, und ihre Bewegung und Orientierungsänderungen in einem einheitlichen Bezugssystem über die Zeit getrackt werden können. Durch die Vielzahl unterschiedlicher Objekte und Bewegungsmuster sind hier Multi-Modellansätze erforderlich. Alternativ soll untersucht werden, inwiefern Teile dieser Aufgabe bereits innerhalb der neuronalen Netzwerkarchitektur gelöst werden können.

Das im Rahmen des vorgeschlagenen Projekts entwickelte Sensorsystem zur autonomen Umfelderfassung auf Binnengewässern soll auf dem bereits existierenden autonomen Wasserfahrzeug und dem Wasserroboter des ISD installiert werden. Dabei sind zwei exemplarische Anwendungen zur Kollisionsvermeidung und automatisiertem Anlegen angestrebt. Mittels Kombination optischer, systemtechnischer und Machine-Learning-Methoden soll die optische Umgebungserfassung auf Basis multipler nicht-registrierter Sensoren geschehen. Die unmittelbare Nähe der Projektteilnehmer sowie assoziierten Partnern Katamaran-Reederei Bodensee, ZF Friedrichshafen AG, Konsortium Autonomes Fahren und Robert Bosch GmbH zum Bodensee, bietet optimale Bedingungen für eine erfolgreiche Umsetzung des Projektes.

Autonome Dockingversuche

Nach grundlegendem Umbau des Forschungsbootes Solgenia der Fakultät Elektro- und Informationstechnik konnte sie im Sommer 2020 wieder zu Wasser gelassen werden. Der Umbau wurde im Hinblick auf die Zukunftsfähigkeit für die Forschung in den Bereichen autonomer Systeme und alternativer Antriebe maßgeblich unter der Leitung des ISD-Konstanz durchgeführt. Bereits im Dezember 2020 konten erste vollautonome Anlagemanöver erfolgreich getestet werden (siehe Videos). Die Videos zeigen in der oberen Zeile Dockingversuche bei moderatem Seegang, in der unteren Spalte bei starkem Wind. Hierbei kamen am ISD Konstanz entwickelte Algorithmen zum Einsatz.