Master

Audioedit SS10

Die Standard Audiotreiber unter Windows lassen nur eine 2-kanalige (Stereo) -Verarbeitung von Audioquellen zu. Um trotzdem mit Soundkarten mit mehreren Kanälen arbeiten zu können, wurde von Steinberg das Audio Stream Input/Output (ASIO) Protokoll entwickelt. Mit diesem Protokoll ist der Zugriff auf mehrkanalige Soundkarten mit geringer Latenz möglich. Die meisten Hersteller von professionellen Soundkarten liefern für ihre Hardware ASIO-Treiber aus, die jedoch meist nur mit kommerzieller Software genutzt werden können. In diesem Projekt soll eine Software zur mehrkanaligen Audioverarbeitung entwickelt werden, mit deren Hilfe auch Bearbeitungs- und Analysefunktionen durchgeführt werden können. Dieses System besteht aus folgenden Komponenten:

- einem mehrkanaligen Audiorecorder

- einem AudioEditor, mit dem Audiodateien bearbeitet werden können. Die eigentlichen Bearbeitungswerkzeuge werden als Plugins realisiert. Der Editor dient also als Hostsystem und Benutzerschnittstelle zum Ausführen der Plugins. Die Plugins dienen vor allem zur Analyse der Audiodaten, daher sollte der Editor auch eine Möglichkeit zur grafischen Ausgabe von Messergebnissen bereitstellen.

- ein Framework zum Entwickeln entsprechender Analyse- und Bearbeitungsplugins.

Das Framework muss ein API zum Übergeben der Audiodaten und zum Einstellen eventueller Parameter bereitstellen.

Bluephone WS09

In dem MSI Projekt BluePhone wurde eine Software entwickelt durch die ein PC oder Laptop in Verbindung mit einem Mobiltelefon als Freisprecheinrichtung fungiert. Über eine Graphische-Benutzeroberfläche lassen sich typische Funktionen eines Mobiltelefons am PC nutzen.

Dazu gehört, dass ein PC, ausgestattet mit der notwendigen Audio-Hardware sowie Mikrophon und Lautsprecher, als Freisprecheinrichtung für ein Mobiltelefon dient.

Um die Sprachqualität der Freisprecheinrichtung zu steigern und Audio-Filter sowie Algorithmen zur Sprachverbesserung, wie beispielsweise Echokompensation und Rauschunterdrückung zu testen und zu evaluieren, wurde ein Plug-In Konzept entwickelt, über welches Algorithmen dynamisch integriert werden können. Es ist außerdem möglich, das Adressbuch des Telefons über Bluephone zu synchronisieren und zu verwalten. Die Kommunikation zwischen Laptop und Handy wurde kabellos über Bluetooth realisiert.

Der Kern der Applikation sowie die Graphische Benutzeroberfläche wurden in Java geschrieben. Damit die Funktionalitäten einer Freisprecheinrichtung genutzt werden können, wurde das HFP Profile (Handsfree-Profile) gewählt, welches die meisten Mobiltelefone unterstützen. Auf der PC-Seite kommt die Open Source Bibliothek HFP for Linux zu Einsatz. Diese steht als DBus-Daemon zur Verfügung und kann über die offizielle Java-DBus API angesprochen werden. Das Plug-In Konzept zur Integration von Sprachalgorithmen wurde in C++ als eigenständigen Server implementiert. Dies resultiert daher das die zu testenden Algorithmen in der Regel in C oder C++ implementiert werden. Die Kommunikation zur Java Applikation erfolgt über eine lokale TCP Verbindung. Für die Synchronisation zwischen der Applikation und dem Handy kommt SyncML zum Einsatz.

Bachelor

Bluetooth-Freisprecheinrichtung

Der Kurzstreckenfunk-Standard Bluetooth hat sich auf breiter Front durchgesetzt. Immer mehr Geräte können über Bluetooth kabellos miteinander kommunizieren. Zur einfachen Integration der Bluetooth-Kommunikation in eingebettete Systeme bieten verschiedene Hersteller komplette Bluetooth-Module an, die über die serielle Schnittstelle mittels Modembefehlen (AT Kommandos) gesteuert werden können.

Im Rahmen des Projekts soll mit Hilfe des Bluetooth-Moduls BISM II der Firma Ezurio (http://www.ezurio.com/products/bism/) eine Freisprecheinrichtung implementiert werden. Das Modul enthält bereits den kompletten Protokoll-Stack für die erforderlichen Bluetooth Profile (Handsfree Profile und Headset Profile). Die Projektgruppe sollte die Ansteuerung des Moduls über die serielle Schnittstelle implementieren. Um eine einfache Portierung auf ein DSP-System zu ermöglichen, sollte die Umsetzung in ANSI-C erfolgen.

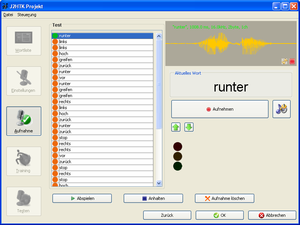

Entwurf eines robusten Kommandoerkenners WS07/08

Spracherkennung findet zunehmend Anwendung im Bereich von Sprachbediensystemen (z.B. im PKW) oder Diktiersystemen. Die entsprechenden Systeme können bereits einen Wortschatz von mehreren Tausend Worten erkennen und unterstützen komplexe Dialoge z.B. zur Zieleingabe für Navigationssysteme.

Im Rahmen des Projekts soll ein einfacher Kommando-Worterkenner aufgebaut werden, der einen kleinen Wortschatz von ca. 20-40 Worten robust und sprecherunabhängig erkennt. Ziel ist dabei eine möglichst einfache Implementierung, die sich für den Einsatz im Rahmen einer Vorlesung zur Mensch-Maschine-Kommunikation eignet.

Basis für die Implementierung ist das Hidden Markov Model Toolkit (HTK) der Cambridge University (http://htk.eng.cam.ac.uk/).

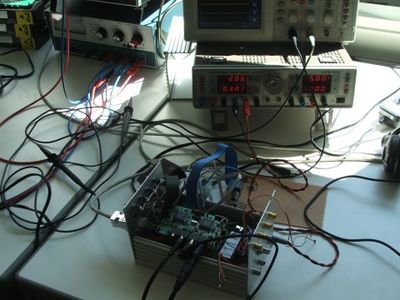

Messtechnik für Freisprechsysteme SS07

Eine Freisprechanlage soll verkehrssicheres Telefonieren in Fahrzeugen gewährleisten. Um die Qualität einer Freisprecheinrichtung ermitteln und bewerten zu können, wurde vom Verband der Automobilindustrie (VDA) ein standardisiertes Messverfahren entworfen. Dieses Verfahren ist jedoch sehr aufwändig. Ziel dieses Projekts ist die Entwicklung eines DSP-Systems, das diesen Messaufwand erheblich reduziert. Das System vermisst hierzu einmalig die Fahrzeugakustik. Bei den Messungen nach dem VDA-Standard wird die akustische Ausbreitung durch das DSP-System simuliert. Die akustischen Ausbreitungspfade im Fahrzeug werden durch lange FIR-Filter modelliert. Dies erfordert eine mehrkanalige Filterung mit extrem kurzer Latenzzeit.

Das System vermisst hierzu einmalig die Fahrzeugakustik. Bei den Messungen nach dem VDA-Standard wird die akustische Ausbreitung durch das DSP-System simuliert. Bei der Simulation tritt also der DSP anstelle der realen Fahrgastzelle. Das folgende Schaltbild verdeutlicht dieses Prinzip:

Zur Beschreibung der Fahrzeugakustik gehen wir von einem Freisprechsystem (FS) mit zwei Mikrofonen im Innenspiegel aus. Die akustischen Wege im Fahrzeug sind in Abbildung 3 dargestellt. Die Pfeile symbolisieren dabei die Wege der Schallwellen, welche bei der Systemmessung- und simulation berücksichtigt werden müssen.

Pfad 1 in der obigen Abbildung repräsentiert den akustischen Weg vom Lautsprecher zum rechten Ohr des Fahrers. Das rechte Fahrerohr wird dabei als Referenz für die Wahrnehmung des fernen Gesprächsteilnehmers gewählt. Die Wege 2 und 3 entsprechen den Echopfaden, d.h. den akustischen Wegen des Lautsprechersignals zu den beiden Mikrofonen der Freisprecheinrichtung. Die Wege 4 und 5 modellieren die akustische Ausbreitung der Fahrersprache zu den beiden Mikrofonen der Freisprecheinrichtung. Für das Messen der Echodämpfung in sogenannten Double-Talk Situationen (naher und ferner Sprecher sind aktiv) muss sowohl die Senderichtung als auch die Empfangsrichtung aktiv sein, d.h. in einer entsprechenden Simulation müssen die Pfade 2-5 gleichzeitig simuliert werden.

Der DSP in Aktion ...